GPT-5 连个旅游攻略都做不出?阿里 DeepPlanning 揭秘:只会聊天的AI离“真管家”还差得远

论文摘要

论文标题 :DEEPPLANNING: Benchmarking Long-Horizon Agentic Planning with Verifiable Constraints

论文网址:https://arxiv.org/pdf/2601.18137

中文标题 :DEEPPLANNING:具有可验证约束的长远期智能体规划基准测试

发布机构 :阿里巴巴 Qwen Team(通义千问团队)

核心作者 :Yinger Zhang, Shutong Jiang, Renhao Li, Jianhong Tu, Junyang Lin 等

关键词 :AI智能体(Agents)、长远期规划(Long-Horizon Planning)、全球约束优化(Global Constrained Optimization)、基准测试(Benchmark)、推理模型(Reasoning Models)

一句话总结: 这篇论文(DeepPlanning)发布于2026年1月(基于您提供的上下文时间),由阿里巴巴Qwen团队撰写。它直击了当前AI Agent(智能体)领域的最大痛点: 只会耍嘴皮子,真干起复杂活儿来就“顾头不顾腚”。

1. 为什么我们需要这就这篇论文?(背景与痛点)

1.1 从“工具人”到“策划师”的跨越

在前两年(2023-2024),我们评价一个AI厉不厉害,往往看它能不能听懂指令去调用一个工具。比如你问:“今天天气怎么样?”AI调用天气API,告诉你“晴转多云”。这叫 单步工具调用 。

但是,到了2026年的今天,我们对AI的期望变了。我们希望它能像一个真实的私人助理。比如你说:“ 帮我规划下周去北京的5天行程,一家四口,预算2万,要住有洗衣机的酒店,还得去环球影城,但我不想坐红眼航班。 ”

这就不是简单的“查天气”了。这需要AI具备 长远期规划(Long-Horizon Planning) 的能力。

1.2 现有测试的“虚假繁荣”

论文作者指出,现有的AI评测集(Benchmarks)大多在“自欺欺人”:

太局部 :只测试AI会不会选酒店,却不管选了酒店后,剩下的钱够不够买机票。

太简单 :信息往往直接给到了AI,不需要AI自己去环境里“翻箱倒柜”找信息。

评估太水 :很多评测是用另一个LLM(大模型)来给AI打分,这就好比“让学生互相改卷子”,不仅不客观,还容易放水。

DeepPlanning 的诞生,就是为了撕开这层遮羞布,用最真实、最硬核、甚至有点“变态”的约束条件,来测试现在的顶尖AI(如GPT-5系列、Claude-4.5系列、Qwen3系列)到底能不能在现实世界中活下来。

2. DeepPlanning 是什么?核心解决了什么问题?

DeepPlanning 是一个全新的、高难度的基准测试框架。它不仅仅是给AI出题,而是构建了一个 “高保真”的模拟现实世界 。

2.1 三大核心能力大考

作者认为,一个合格的“规划型AI”必须同时具备以下三项能力(缺一不可):

主动信息获取(Proactive Information Acquisition) :

大白话:用户没告诉你的信息,你要自己去查,别等着喂。

例子:用户要去某个景点,但没说具体在哪。AI得自己查坐标,查完还得查附近的交通工具,不能瞎编。

局部约束推理(Local Constrained Reasoning) :

大白话:搞定每一个小环节的具体要求。

例子:用户说“我要买一双阿迪达斯TechFit的鞋,评分要4.5以上”。AI必须在成千上万的商品中筛选出符合这一堆条件的那个。

全局约束优化(Global Constrained Optimization)——这是最难的!

大白话:拆东墙补西墙,统筹全局。所有的决定加在一起,不能崩盘。

例子:你的酒店选得太贵,导致最后没钱买门票了;或者你为了省钱选了便宜航班,结果落地时间太晚,赶不上预定的晚餐。AI必须在 时间、金钱、空间 这三个维度上同时走钢丝,找到那个唯一的“完美解”。

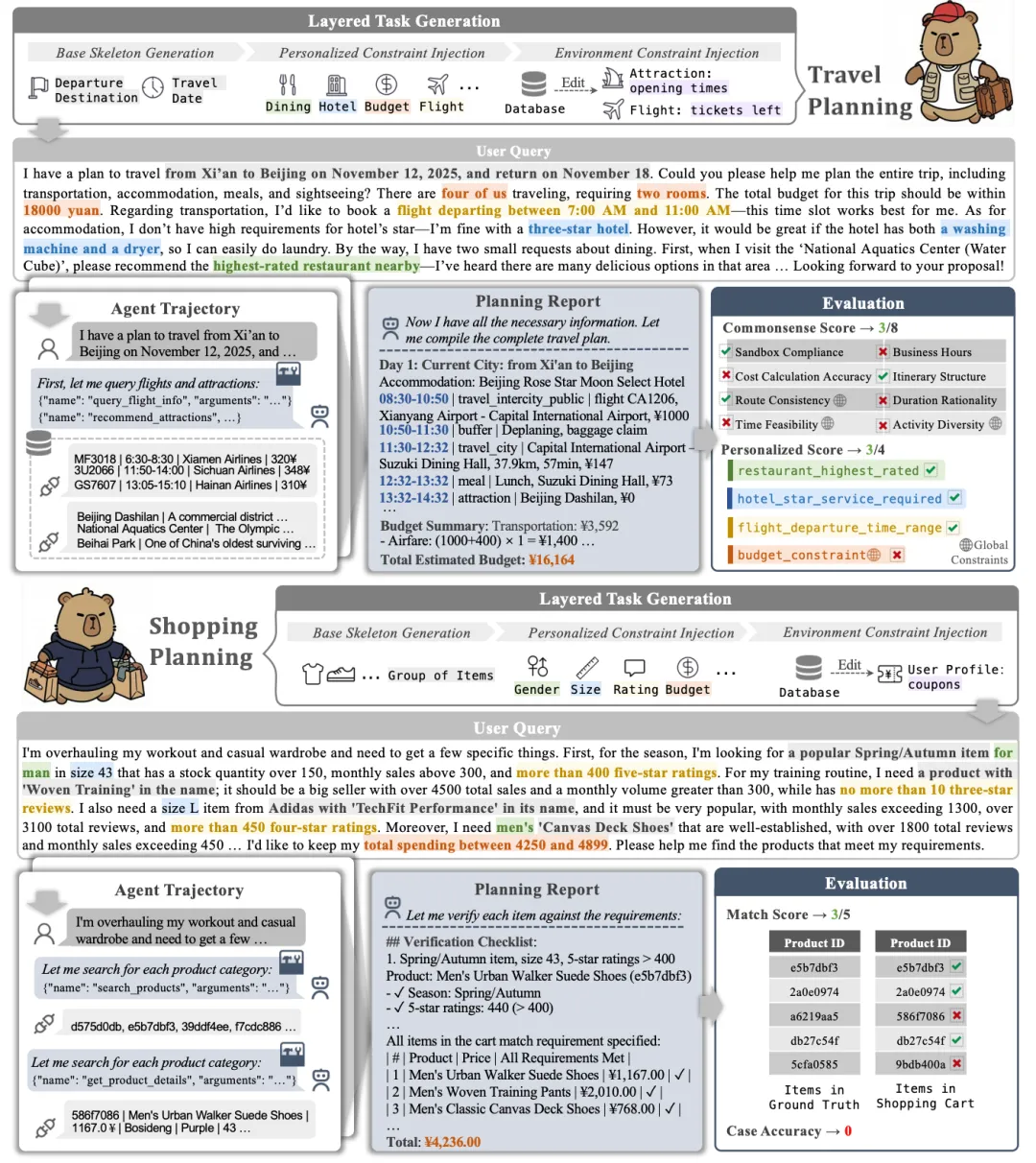

3. 两大“地狱级”测试场景

为了测试上述能力,DeepPlanning 构建了两个极度接近真实生活的场景: 旅行规划(Travel Planning) 和 购物规划(Shopping Planning) 。

3.1 场景一:多日旅行规划 (Travel Planning)

这不仅仅是写个游记,而是要生成一份精确到分钟、每一分钱都对得上的 可执行行程单 。

数据规模 :包含120个任务。每个任务都配备了独立的沙盒数据库(包含真实的航班、火车、酒店、餐厅、景点数据)。

硬核约束 :

时间 :活动不能重叠(你不能同时在吃饭和坐飞机);必须考虑路程时间(从酒店到景点要坐车);必须考虑营业时间(人家博物馆周一闭馆,你不能排周一)。

空间 :地理位置要连续(不能上一秒在北京,下一秒在上海,中间没有交通工具)。

预算 :总花费必须卡在预算内。

个性化 :比如“我要住三星级以上且有干衣机的酒店”、“我想去最近评分最高的餐厅”。

这其中的难点在于“连锁反应” :如果你把原本下午3点的景点改到了早上9点,那么你的午餐地点要变,交通方式要变,甚至因为早上票价不同,你的总预算也变了。AI能不能处理这种牵一发而动全身的逻辑?

3.2 场景二:复杂购物规划 (Shopping Planning)

这不仅仅是“买东西”,而是一场 数学与逻辑的博弈 。

任务描述 :用户给你一堆模糊的需求(如“我要买一套春季男士运动装,要销量高的”)和一个总预算。

核心挑战——凑单与优惠券 :

这就是我们双十一遇到的噩梦。

有“跨店满减券”(满1200减200),有“同品牌券”(满400减60)。

AI不仅要找到符合用户喜好的商品,还要计算 怎么组合最便宜 。

有时候,为了用上一张大额优惠券, 买一件稍贵的商品反而会让总价更低 。

这考验的是AI的组合优化能力(Combinatorial Optimization) 。它需要在成千上万种商品组合中,算出一笔糊涂账,确保最终总价是全网最低,且不超过预算。

4. 核心方法论:如何制造“完美难题”?

这一部分非常精彩。为了保证测试的公平性,作者不能随便拍脑门出题。因为如果题目无解,AI做不出来是正常的;如果题目有无数解,怎么评判AI选的是最好的?

Qwen团队采用了一套 “逆向生成” (Reverse-Generation) 的方法来构建数据。

4.1 第一步:不仅要有题,还要有答案库 (Database & Toolbox)

他们先建立了极其详尽的数据库。

旅行库 :包含航班时刻表、票价、酒店设施标签、餐厅评分等。

购物库 :包含商品材质、库存、销量、各种复杂的优惠券规则。

并给AI配备了专门的Python工具(API),比如 query_flight_info(查航班)、add_product_to_cart(加购物车)。

4.2 第二步:分层任务生成 (Layered Task Generation)

这是本文的精髓。他们不是先出题再找答案,而是 先生成答案,再反推题目 。

生成骨架 :先随机生成一个合理的行程骨架(比如:北京到西安,玩3天)。

注入个性化约束 :在这个骨架上加戏。比如,选定了一个特定酒店后,把这个酒店的特征(如“有健身房”)变成用户的要求写进题目里。

注入环境约束(最狠的一步) :

在旅行中,故意把某些景点的开放时间改掉,或者限制机票数量。

在购物中,设计复杂的优惠券规则,使得必须凑单才能达到最优。

关键点 :他们通过算法调整数据库中的其他候选项, 确保在这个约束下,只有唯一的一个最优解(或极少数解) 。

4.3 第三步:人工质检

最后,由人类专家把这些机器生成的逻辑转换成自然的对话语言,确保题目听起来像人话,而不是代码。

这样做的结果是: 每一道题,都有一个标准答案(Ground Truth)。 评测时,不需要GPT-4来打分,直接运行代码验证AI输出的结果是否符合所有硬性指标。这就叫 “可验证约束” (Verifiable Constraints) 。

5. 评测标准:不看广告看疗效

DeepPlanning 抛弃了主观打分,采用了严格的代码级评估。

5.1 旅行规划的评分维度

常识分 (Commonsense Score) :

路线一致性 :你不能瞬移,行程必须闭环。

沙盒合规性 :你选的酒店必须是数据库里真的存在的,价格得对。

时间可行性 :活动不重叠,预留了足够的交通缓冲时间。

营业时间 :没在人家关门的时候去。

成本计算 :加法没算错。

个性化分 (Personalized Score) :用户说要“靠窗的座位”,你满足了吗?

案例准确率 (Case Accuracy) :只有当上述 所有 分数都完美,这个任务才算做对(1分),否则就是0分。这是一个非常苛刻的指标。

5.2 购物规划的评分维度

匹配分 (Match Score) :找到的商品是不是用户想要的?

案例准确率 (Case Accuracy) :不仅商品要对,最终的 总价必须是数学上的最低价 (即完美利用了优惠券规则)。如果比最优解贵一分钱,也算错。

6. 巅峰对决:实验结果深度分析

论文基于2026年的模型环境,测试了当时最顶尖的模型,包括 GPT-5系列(OpenAI)、Claude-4.5系列(Anthropic)、Gemini-3系列(Google)、Qwen3系列(Alibaba)、DeepSeek-V3.2 等。

6.1 谁是王者?(模型排名)

结果令人震惊: 即使是2026年的最强模型,也被DeepPlanning虐得很惨。

总体表现 :虽然各家都在吹嘘自己有多强,但在旅行规划任务上,即使是表现最好的模型(GPT-5.2-high),完全做对的概率也只有 35.0% 。

推理模型 vs 非推理模型 :

这是本文的一大发现。那些具备“慢思考”(Thinking/Reasoning)能力的模型(如OpenAI o3, Claude-4.5-Opus w/ thinking, Qwen3-Max w/ thinking) 全面碾压 了那种反应很快但思考不深的模型。

数据对比 :在旅行规划中,开启“思考模式”的Claude-4.5-Opus得分为33.9,而不开启时只有26.3。这证明了 System 2(慢思考)对于解决复杂规划问题是必须的。

6.2 成本与效果的权衡

工具调用次数 :为了做好一个旅行计划,表现最好的GPT-5.2-high平均每个任务要调用 224次 工具(查航班、比价、查地图等)。这说明, 要想聪明,就得勤快 。不大量搜集信息,根本不可能做出完美计划。

并行 vs 串行 :

GPT-5.1 喜欢 并行 :一次发出一堆指令“帮我查这5个酒店”。效率高,但容易出错。

GPT-5.2 喜欢 串行 :查完一个,确认无误,再查下一个。虽然慢,交互轮次多(接近100轮),但准确率提升了12.7%。 慢工出细活在AI界依然适用。

6.3 失败原因分析(AI是怎么翻车的?)

通过对 Claude-4.5-Opus 的错误案例分析,作者总结了三大死因:

信息获取失败(Pattern A) :

忘了查关键信息:比如安排了两个景点,却忘了查这两个景点之间有多远,结果安排在同一天,累死用户。

想当然:随着行程变长(比如从2天变成7天),AI需要查的信息量指数级上升,它就开始偷懒,不再去验证每一个细节。

局部推理失败(Pattern B) :

无视用户:用户说“要三星级”,它给推了五星级(可能是因为它觉得五星级更好,但违反了约束)。

隐性约束翻车:比如只有2张机票了,它非要给4个人订票。这种常识性错误依然存在。

全局优化崩溃(Pattern C)——这是重灾区!

预算超支 :这是最典型的。AI往往是先把行程排得很完美,最后算总账发现超了预算。但它 不会回溯(Backtracking) ——它不知道该删掉哪个贵的项目来平衡预算,往往就直接把超支的方案交上来了。

顾此失彼 :在购物任务里,为了凑满减,买了一堆无用的东西,或者为了省单价,错过了总价优惠。AI很难像人类一样在脑子里构建一个全局的数学模型。

7. 核心创新点与价值总结

7.1 为什么这篇论文很重要?

重新定义了“难” :它告诉业界,别再拿那些简单的API调用沾沾自喜了。真正的智能体,必须能处理 多步骤、强约束、长战线 的任务。

揭示了LLM的短板 :即便是GPT-5级别的模型,在面对需要 全局统筹 (Global Optimization)的任务时,依然像个还要补课的小学生。AI缺乏“回溯修改”和“全局校验”的能力。

指明了方向 :

推理能力(Reasoning)是关键 :未来Agent的突破口在于增强模型的逻辑推理和慢思考能力,而不是单纯增加参数量。

搜索与回溯 :未来的AI Agent架构需要引入像AlphaGo那样的搜索算法,不仅要能往前走,还要能在发现路不通时,退回来重新规划。

7.2 给我们的启示

如果你是一个开发者或AI应用的使用者,这篇论文告诉你:

不要轻易相信AI生成的复杂方案(如投资建议、长途旅行、房屋装修)。

目前的AI非常擅长“执行单点任务”,但非常不擅长“统筹全局”。

如果你要开发Agent,必须要在后台加上强有力的 代码校验逻辑(Verifier) ,不能完全依赖大模型自己的输出来保证正确性。

8. 结语

DeepPlanning 就像是AI界的一次“铁人三项”赛。它无情地暴露了当前看似强大的AI在面对真实世界复杂性时的脆弱。

虽然我们在2026年已经拥有了GPT-5和Claude-4.5这样强大的工具,但要让AI真正成为一个让你放心的“全能管家”,我们还有很长的路要走。这篇论文不仅是一个测试标准,更是通往下一代 可信赖、强推理智能体 的藏宝图。

它提醒我们: 真正的智能,不在于吟诗作对,而在于如何在条条框框的现实约束中,找到那条最优的路径。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~